W poprzednim wpisie dotyczącym usług katalogowych opisałem proces instalacji serwera OpenLDAP. Dzisiaj, zgodnie z zapowiedzą przedstawię sposób konfiguracji tej aplikacji oraz zaprezentuję to jak ona działa.

Konfiguracja

Proces konfiguracji sprowadza się do wprowadzeniu w pliku /usr/local/etc/openldap/slapd.conf odpowiednich wartości dla poszczególnych parametrów.

Na podstawie powyższych danych wprowadzamy zmiany w pliku:

Uruchamianie

Aby uruchomić serwer OpenLDAP, należy wydać polecenie:

Sprawdźmy teraz czy serwer odpalił się poprawnie i czy odpowiada zgodnie z konfiguracją na zapytania, które można zlecić do wykonania za pomocą komendy ldapsearch. Wykonajmy poniższą komendę:

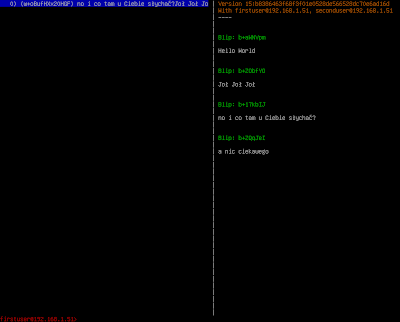

Poniższy zrzut ekranu prezentuje wynik, jaki uzyskałem dla mojej konfiguracji.

Podsumowanie

Konfiguracja oraz uruchamianie aplikacji nie wymaga włożenia wiele wysiłku, jednak aby zapewnić większe bezpieczeństwo całej aplikacji należy zapoznać się z następującą lekturą udostępnioną na stronie OpenLDAP.

Wydaje się, że cykl dotyczący usług katalogowych można już zamknąć. Temat ten opisywałem z ważnego powodu - planuję zintegrować OpenLDAP z innym systemem. Zanim postawię kropkę nad "i" w ostatnim "odcinku" wprowadzę do działającej instancji serwera usług katalogowych dane z których zamierzam skorzystać w przyszłości.

Konfiguracja

Proces konfiguracji sprowadza się do wprowadzeniu w pliku /usr/local/etc/openldap/slapd.conf odpowiednich wartości dla poszczególnych parametrów.

Jednym z parametrów, który należy określić jest hasło użytkownika zarządzającego serwerem, aby uniknąć wpisywania tego hasła w sposób czytelny można skorzystać z narzędzia slappasswd. Pozwala ono wygenerować zaszyfrowany ciąg hasła, który następnie można bezpiecznie umieścić w pliku konfiguracyjny. Wygeneruję zatem taki ciąg wydając polecenie i podając odpowiednie dane

- slappasswd

Wynik działania zaprezentowano powyżej.

Założyłem dodatkowo, że serwer będzie pracował w domenie: mbsoftware.com.pl, a administrator będzie nazywał się po prostu: admin.

Teraz możemy przystąpić do wprowadzania wartości w wymienionym wcześniej pliku. Przykładowy szablon pliku znajduje się poniżej:

database bdb

suffix "dc=,dc=<1-WSZY_CZŁON_DOMENY>"

rootdn "cn=,dc= ,dc=<1-WSZY_CZŁON_DOMENY>"

rootpw

directoryZnając domenę, nazwę użytkownika oraz ciąg, który będzie reprezentował hasło pozostaje nam do określenia katalog - np. /usr/local/var/openldap-data - trzeba zadbać, aby przed uruchomieniem aplikacji został on utworzony.

Na podstawie powyższych danych wprowadzamy zmiany w pliku:

database bdb

suffix "dc=mbsoftware,dc=com,dc=pl"

rootdn "cn=admin,dc=mbsoftware,dc=com,dc=pl"

rootpw {SSHA}Uer3DSw297HyPvs25Z4u3tnyp2hrUB8i

directory /usr/local/var/openldap-dataNie możemy zapomnieć o utworzeniu wyżej wymienionego katalogu. Poniżej fragment pliku slapd.conf oraz zmiany, które w nim wprowadziłem.

Uruchamianie

Aby uruchomić serwer OpenLDAP, należy wydać polecenie:

- sudo /usr/local/libexec/slapd

Sprawdźmy teraz czy serwer odpalił się poprawnie i czy odpowiada zgodnie z konfiguracją na zapytania, które można zlecić do wykonania za pomocą komendy ldapsearch. Wykonajmy poniższą komendę:

- ldapsearch -x -b '' -s base '(objectclass=*)' namingContexts

Poniższy zrzut ekranu prezentuje wynik, jaki uzyskałem dla mojej konfiguracji.

Podsumowanie

Konfiguracja oraz uruchamianie aplikacji nie wymaga włożenia wiele wysiłku, jednak aby zapewnić większe bezpieczeństwo całej aplikacji należy zapoznać się z następującą lekturą udostępnioną na stronie OpenLDAP.

Wydaje się, że cykl dotyczący usług katalogowych można już zamknąć. Temat ten opisywałem z ważnego powodu - planuję zintegrować OpenLDAP z innym systemem. Zanim postawię kropkę nad "i" w ostatnim "odcinku" wprowadzę do działającej instancji serwera usług katalogowych dane z których zamierzam skorzystać w przyszłości.